Integração estratégica visa compreensão holística do mundo físico e digital

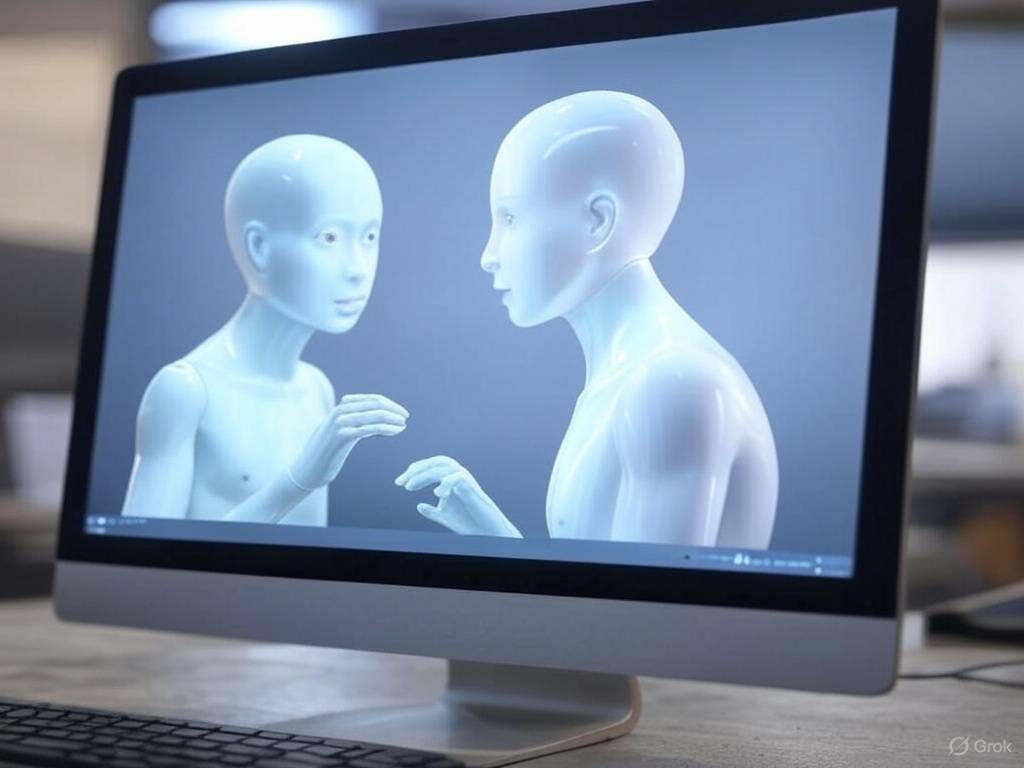

O Google está trabalhando em uma integração estratégica de seus modelos Gemini e Veo, sinalizando uma nova direção para seus assistentes de IA. Esta fusão representa uma abordagem unificada à compreensão multimodal do mundo, combinando as capacidades avançadas de processamento de linguagem do Gemini com as habilidades de visão computacional do Veo.

A visão por trás desta integração, segundo Demis Hassabis, é criar um sistema capaz de compreender e interagir com o mundo físico de maneira mais holística. Um assistente verdadeiramente universal precisaria processar e analisar simultaneamente texto, imagens, vídeos e potencialmente outros formatos de dados como áudio e sinais de sensores, de forma integrada e contextual.

Para ilustrar o potencial desta abordagem, considere um cenário em que um usuário mostra ao assistente uma imagem de sua geladeira e pergunta o que poderia cozinhar com os ingredientes disponíveis. Um sistema genuinamente multimodal não apenas identificaria os itens visíveis, mas compreenderia o contexto da pergunta, consideraria preferências alimentares previamente expressas, e poderia sugerir receitas otimizadas para os ingredientes específicos, tempo disponível e nível de habilidade culinária do usuário.

Esta evolução representa uma mudança significativa no campo da IA assistiva. Em vez de oferecer múltiplas ferramentas especializadas para diferentes tarefas, o Google está trabalhando para criar um assistente versátil e adaptável que possa compreender e responder a uma ampla gama de necessidades em diversos contextos, desde ambientes profissionais até domésticos.